近日,苹果公司在最新研究成果中,正式推出一款具备图像理解与生成双重能力的新型图像模型 ——Manzano。该模型的研发成功,有效攻克当前开源图像模型在 “理解” 与 “生成” 能力难以兼顾的技术难题,其图像处理效率与效果已接近 OpenAI、谷歌等企业提供的商业级系统,为行业技术发展提供新方向。

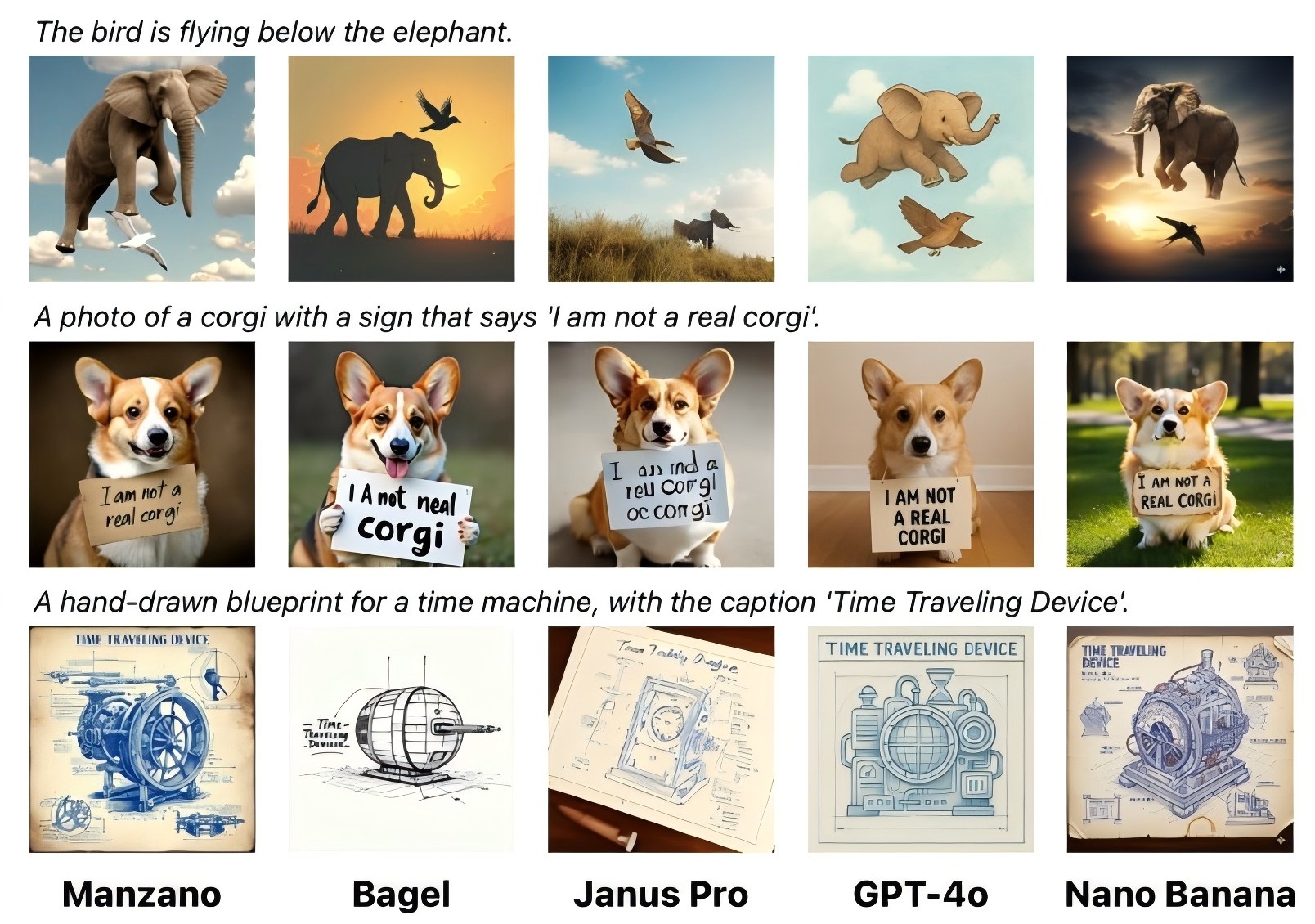

目前,Manzano 模型暂未对外发布,亦未开展公开演示。苹果研究团队通过发布研究论文及配套低分辨率图像样本,展示模型对复杂提示的处理能力,并将其与开源模型 Deepseek Janus Pro、商业系统 GPT-4o 及谷歌 Gemini2.5Flash Image Generation(又称 “Nano Banana”)的输出结果进行对比。在三组高难度提示测试中,Manzano 模型表现与 GPT-4o、Nano Banana 基本持平,验证了其技术实力。

据苹果方面分析,当前多数开源图像模型存在核心限制:需在图像分析能力与生成能力间做出取舍,而商业系统则可实现两者兼顾。尤其在处理含大量文本的任务(如文件读取、图表解读)时,现有开源模型的性能短板更为明显,这一痛点成为行业发展的重要阻碍。

Manzano 模型以 “混合图像标记器” 为核心设计理念,可输出连续标记与离散标记两类标记。其中,连续标记采用浮点数表示图像,主要服务于图像理解功能;离散标记将图像划分为固定类别,为图像生成提供支持。由于两类标记源自同一编码器,大幅降低传统模型中可能出现的功能冲突问题。

在技术架构上,Manzano 模型由混合标记器、统一语言模型及独立图像解码器三部分构成。训练阶段,模型通过融合连续与离散适配器,对语言模型解码器进行优化调整;推理阶段,可同步提供图像理解与生成所需的双数据流。为适配不同场景需求,苹果为模型构建三种不同参数量的图像解码器,参数规模分别为 0.9 亿、1.75 亿、3.52 亿,支持 256 至 2048 像素分辨率的图像处理。

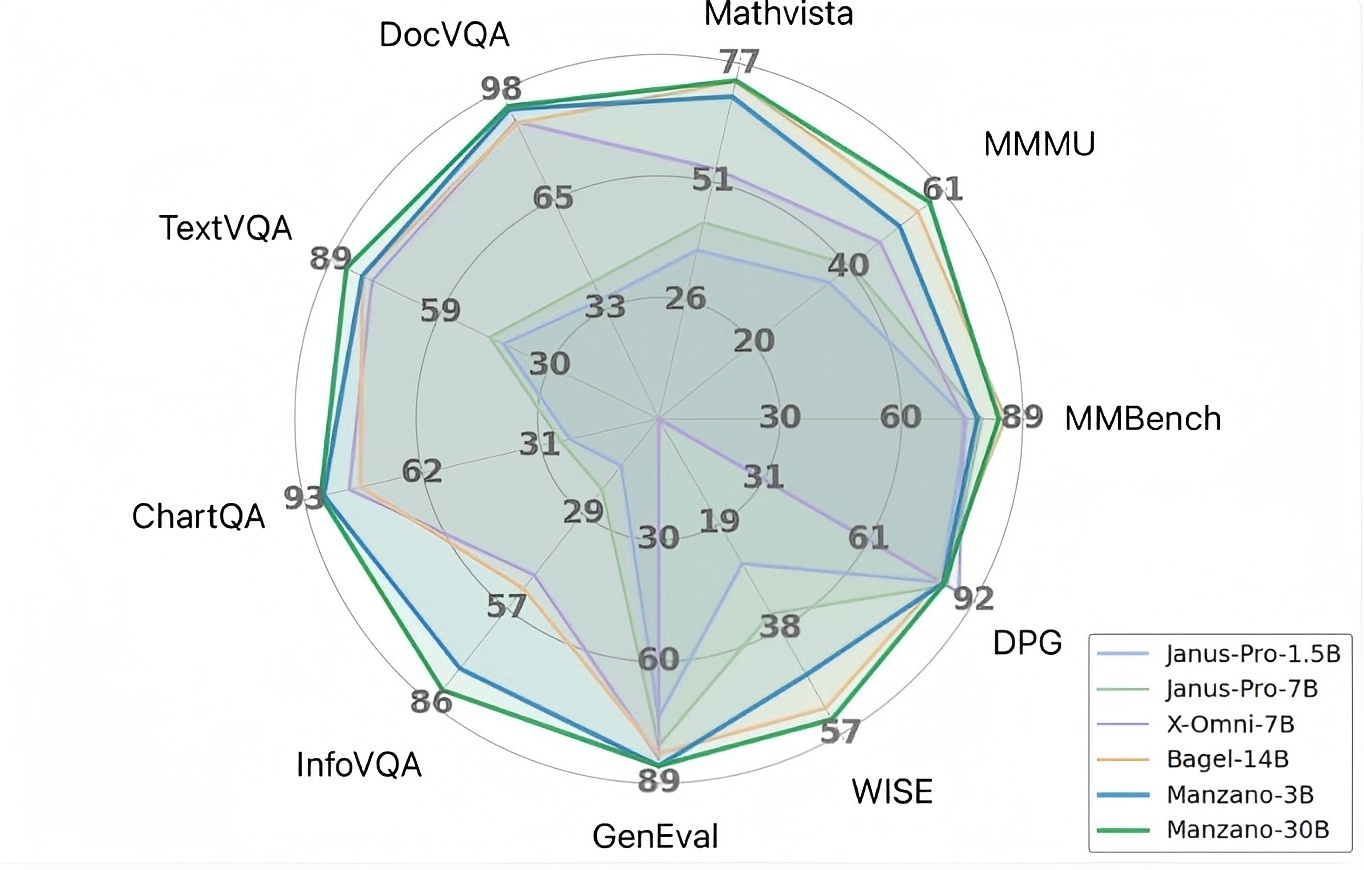

测试结果显示,Manzano 模型在多项基准测试中表现优异,尤其在图表分析、文件解读等文本密集型任务中,30 亿参数版本模型得分突出。研究同时发现,随着模型参数量从 3 亿提升至 30 亿,其综合性能呈现持续优化趋势。