近日,小红书智创音频技术团队正式发布新一代对话合成模型 FireRedTTS-2,该模型的推出标志着对话生成技术在工业级应用领域实现重要突破,为 AI 播客制作及智能音频场景创新提供了强有力的技术支撑,进一步推动音频技术产业高质量发展。

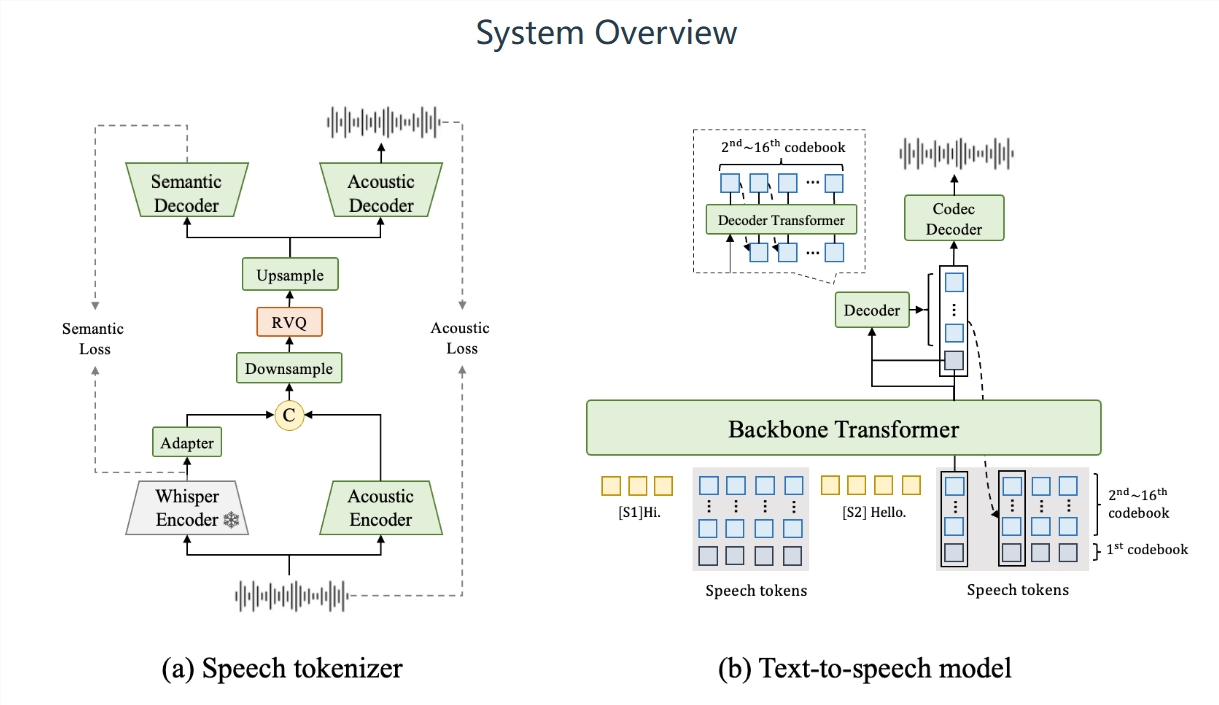

当前对话合成领域普遍存在灵活性不足、发音错误频发、说话人切换稳定性欠佳、韵律自然度欠缺等行业痛点,制约了 AI 音频应用的场景拓展与体验提升。FireRedTTS-2模型研发团队针对上述问题,重点对核心技术模块进行迭代升级,尤其在离散语音编码器与文本语音合成模型两大关键环节实现技术突破。

通过优化算法架构、完善数据训练体系,模型合成效果得到全面提升。经多项权威主客观评测验证,FireRedTTS-2 在语音自然度、发音准确率、多说话人切换稳定性等核心指标上均达到行业领先水平,成功为多说话人对话合成场景提供了更高效、更优质的解决方案。目前,该模型相关技术报告已在国际学术平台 arXiv 正式发布,同时配套上线专用 Demo 及代码链接,便于行业伙伴、科研机构开展技术验证与应用探索,助力推动对话合成技术领域的协同创新。

FireRedTTS-2 在技术特性与功能适配方面展现出显著优势。在语音合成自然度上,模型可精准捕捉重音分布、情绪起伏及停顿节奏等细节,合成音质流畅自然,高度贴近真人对话效果,有效提升 AI 音频内容的听感体验。

相较于闭源对话生成模型,FireRedTTS-2 不仅能稳定输出高质量播客音频,更具备高效的音色克隆功能 —— 仅需获取目标发音人单句语音样本,模型即可精准复刻其音色特征与说话习惯,并自动生成完整对话内容。这一核心功能使其在开源对话合成领域形成差异化竞争优势,为个性化音频制作提供了更多可能。

在技术适配性与场景响应效率上,FireRedTTS-2 同样表现突出。模型支持中文、英语、日语、韩语、法语等多语种语音合成,可满足跨语言音频应用需求;通过采用低帧率离散语音编码器,大幅提升了语音合成的速度与运行稳定性,保障大规模场景下的高效应用;依托双 Transformer 模型架构,进一步增强合成语音的连贯性与自然度,优化复杂对话场景的呈现效果。此外,该模型具备低数据依赖特性,仅需少量训练数据即可完成专属音色定制,能够快速适配不同行业、不同场景的个性化需求,显著降低技术应用门槛。