近日,人工智能领域传来重要突破 —— 知名 AI 企业 DeepSeek 的研究团队于周一正式发布实验性新模型 V3.2-exp。

该模型凭借独创的 “稀疏注意力” 机制,在长上下文操作的推理成本优化方面取得里程碑式进展,为 AI 行业降本增效提供全新解决方案。

目前,相关技术成果已同步在 Hugging Face 平台及 GitHub 开源社区上线,并配套发布详细学术论文,供全球开发者与研究机构参考验证。

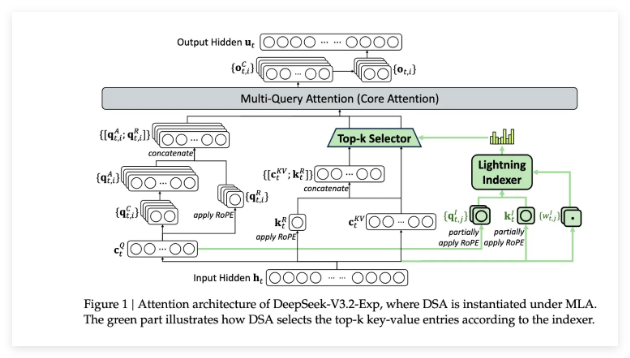

作为 V3.2-exp 模型的核心技术亮点,DeepSeek 稀疏注意力机制通过 “双模块协同” 架构实现高效运行。

其一,“闪电索引器” 模块可快速对上下文窗口内的信息片段进行优先级排序,精准筛选高价值内容;

其二,“细粒度标记选择系统” 能够从已排序的优先摘录中进一步提取关键标记,并将其高效加载至有限的注意力窗口。

这种分层筛选、精准聚焦的技术路径,有效降低了服务器在处理长上下文任务时的负载压力,同时保障了模型对关键信息的捕捉精度,实现 “效率” 与 “性能” 的双重平衡。

从实际测试数据来看,V3.2-exp 模型展现出显著的成本优势。据 DeepSeek 官方披露,在长上下文操作场景中,该模型可使简单 API 调用成本降低幅度高达 50%,大幅缓解了 AI 应用落地过程中的运营成本压力。

尽管当前测试结果为企业内部初步验证数据,仍需第三方机构进一步测试确认,但考虑到该模型已采用 “开放权重” 模式,并在 Hugging Face 平台免费开放,行业内可快速开展广泛的实际应用测试,其真实性能与成本优化效果将在短期内得到全面验证,为技术落地奠定基础。

此次 V3.2-exp 模型的发布,是 DeepSeek 在 AI 推理成本优化领域的重要布局,也成为近期全球 AI 行业聚焦 “降本” 创新的代表性成果之一。

在 AI 技术发展过程中,成本控制分为 “训练成本” 与 “推理成本” 两大核心方向,此前 DeepSeek 推出的 R1 模型以低成本强化学习训练技术引发行业关注,而此次 V3.2-exp 模型则聚焦推理环节,通过优化基础 Transformer 架构的运行效率,进一步完善企业在 AI 全链路成本优化的技术矩阵。

作为今年 AI 热潮中备受关注的创新企业,DeepSeek 此次推出的稀疏注意力技术,虽未像 R1 模型那样引发颠覆性轰动,但其为全球 AI 供应商提供了可落地、可复用的成本优化经验。

随着该技术的推广应用,有望推动整个 AI 行业在推理成本控制领域形成技术共识,加速构建更经济、更高效的 AI 服务生态,为 AI 技术在千行百业的规模化普及注入新动能。