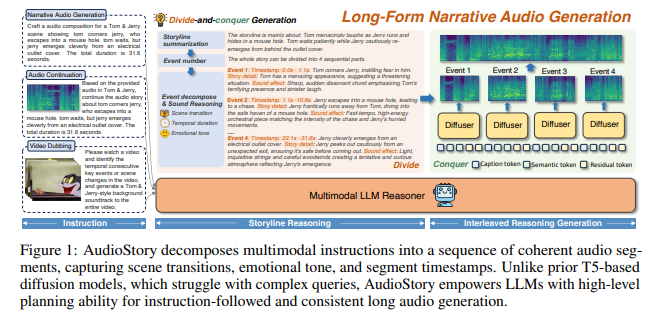

近日,腾讯 ARC 实验室正式发布 AudioStory 技术,该技术在 AI 音频生成领域实现重大突破,将人工智能对音频的处理能力从单一声音模拟提升至复杂叙事构建层面,为相关行业应用开辟了全新空间。

作为一项创新性技术成果,AudioStory 实现了大语言模型与文生音频系统的深度融合,解决了传统 AI 模型在复杂音频编排上的技术瓶颈。传统模型仅能完成单一音效的生成,而 AudioStory 通过 “分而治之” 的核心策略,可将复杂的叙事描述拆解为有序的音频事件序列,并为每个事件配备精准的时间、情绪及场景参数。以 “悬疑追逐战” 场景为例,系统能自动分解出脚步溅水、雷声轰鸣、汽车打滑、大门关闭等关键音频元素,并按照叙事逻辑进行有机组合,形成具有完整叙事性的音频内容。

该技术的另一核心创新在于 “解耦式连接机制”。通过语义令牌与残差令牌的协同作用,构建起精准传递叙事含义与细腻还原音频质感的 “双向桥梁”,可完美呈现诸如雨声由细密到急促、雷声由远及近等具有层次变化的音效细节,大幅提升了音频的真实感与表现力。

在模型训练方面,AudioStory 采用三阶段渐进式培养策略:第一阶段夯实单音频生成基础能力,第二阶段强化音频理解与生成的协同性,第三阶段实现长篇叙事音频的统一处理。经基于一万个标注样本的 AudioStory-10K 基准数据集测试,该技术在指令遵循能力上较同类产品高出 17.85%,在音频质量、时长匹配度及叙事连贯性等关键指标上均处于领先水平。