2025年8月21日,国内人工智能企业深度求索(DeepSeek)正式推出了新一代大语言模型DeepSeek-V3.1。此次发布被视为该平台“迈向Agent时代的第一步”,在模型架构、推理效率和智能体能力等方面实现了显著突破。

DeepSeek-V3.1引入了创新的混合推理架构,使得单一模型同时支持“思考模式”与“非思考模式”。用户现在可以通过官方App与网页端的“深度思考”按钮,根据需求自由切换两种模式。思考模式致力于更深入、准确的推理,而非思考模式则追求更快的响应速度。这种设计让用户能够根据任务需求,在速度与精度之间灵活选择。

经过思维链压缩训练,V3.1-Think在输出token数减少20%-50% 的情况下,各项任务的平均表现与前代R1-0528模型持平。在AIME 2015、GPQA、liveCodeBench等多项评测中,V3.1-Think保持了与R1-0528相当的性能水平,但token消耗量显著降低。效率提升意味着更快的响应速度和更低的计算成本。

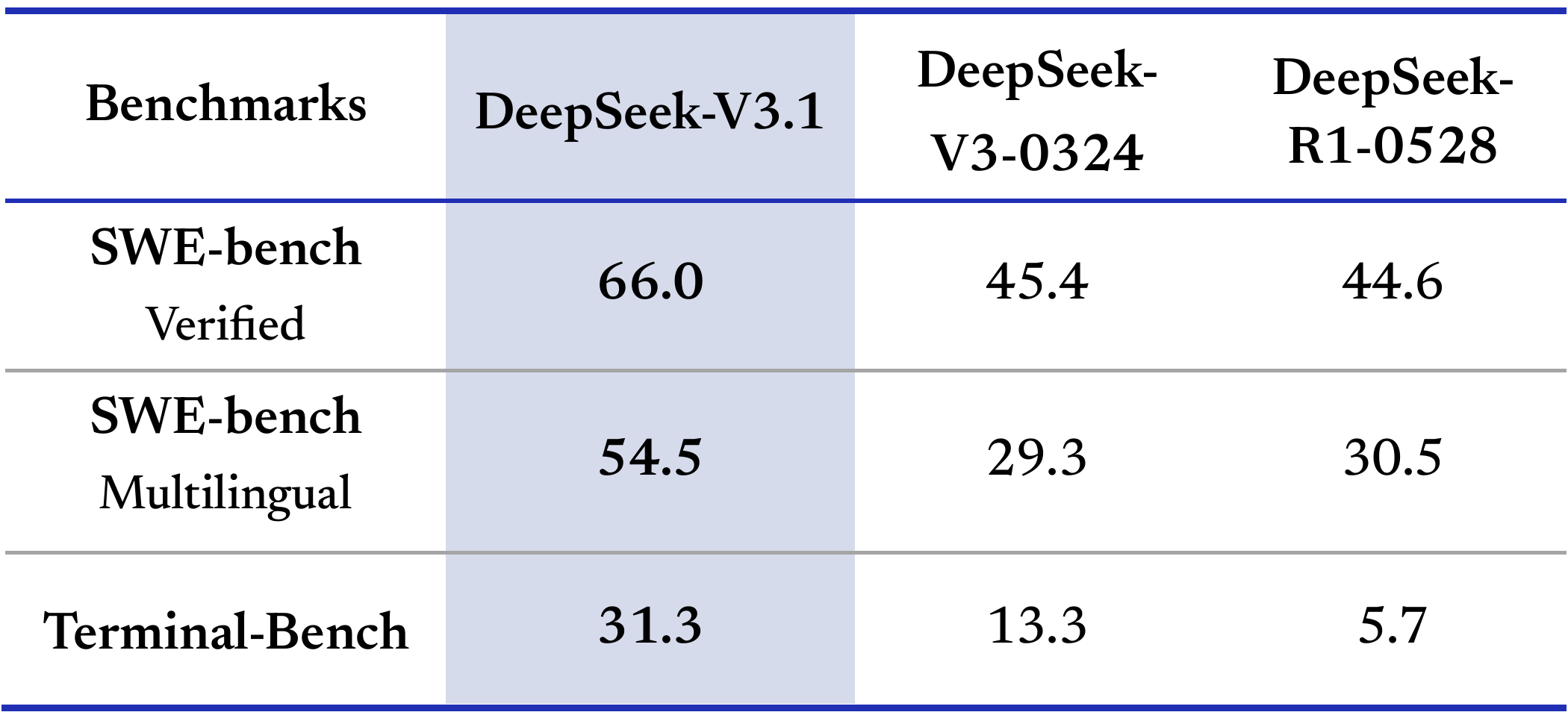

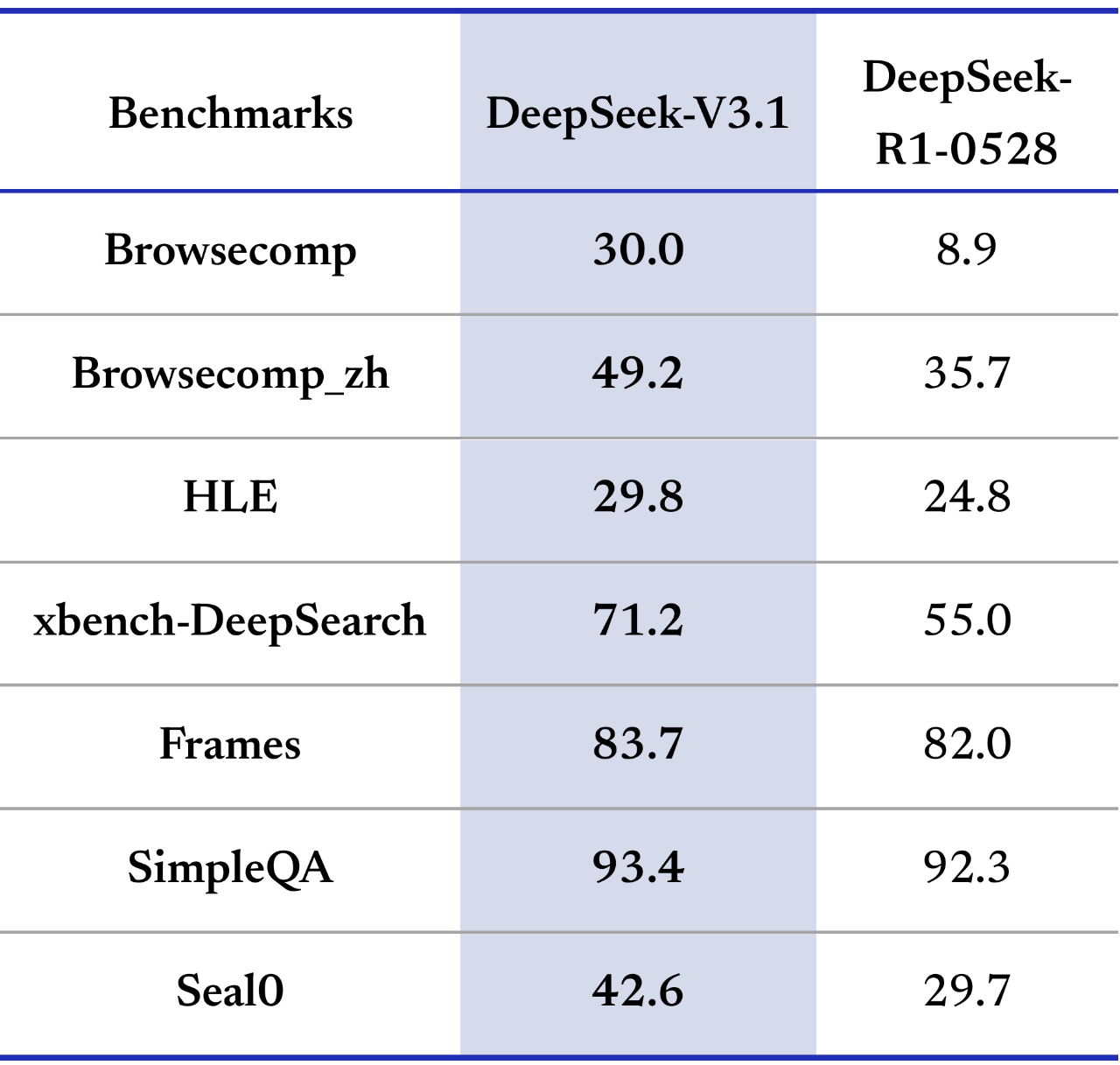

通过后训练优化,DeepSeek-V3.1在工具使用与智能体任务中的表现有了较大提升。在编程智能体测试中,包括代码修复(SWE)与命令行终端环境下的复杂任务(Terminal-Bench)测试,V3.1相比之前的DeepSeek系列模型有明显提高。搜索智能体方面,在复杂搜索测试(browsecomp)与多学科专家级难题测试(HLE)上,V3.1性能已大幅领先R1-0528。

DeepSeek-V3.1的上下文窗口已从64K扩展到128K tokens,处理长文本能力大幅增强。128K上下文长度相当于约400页书籍的内容,使得模型能够处理更长的文档、更复杂的代码库以及更深入的多轮对话。这一升级让DeepSeek-V3.1在长文档摘要、代码库分析等需要大量上下文的任务中表现出色。

DeepSeek API已同步升级,deepseek-chat对应非思考模式,deepseek-reasoner对应思考模式,且上下文均已扩展为128K。API Beta接口支持了strict模式的Function Calling,以确保输出的Function满足schema定义。同时,增加了对Anthropic API格式的支持,用户可以轻松将DeepSeek-V3.1的能力接入Claude Code框架。

DeepSeek宣布V3.1 Base模型与后训练模型已在Hugging Face与魔搭平台同步开源。V3.1的Base模型在V3的基础上额外训练了840B tokens。该模型采用UE8M0 FP8 Scale参数精度,对分词器及chat template进行了较大调整,与DeepSeek-V3存在明显差异。值得注意的是,此次开源采用MIT许可证,这是一个极为宽松的开源协议,允许自由商用。

DeepSeek-V3.1采用了UE8M0 FP8 Scale参数精度,这一设计专门针对国产芯片优化。官方明确表示,这是为“即将发布的下一代国产芯片”量身定制的技术规范与设计标准。分析认为,这可能指的是华为昇腾910C芯片。此前,DeepSeek R2已经使用华为昇腾910B芯片替代了NVIDIA H100 GPU,使输出成本从每百万token 2.19美元降至0.27美元,降幅接近90%。

DeepSeek宣布将于北京时间2025年9月6日凌晨起,对API接口调用价格进行调整。调整内容包括执行新版价格表并取消夜间时段优惠。在9月6日前,所有API服务仍按原价格政策计费。官方表示,为更好地满足用户的调用需求,已进一步扩容API服务资源。